ChatGPT: Inteligência Artificial tem sido usada para criação de malwares

O ChatGPT tem chamado a atenção de todos por sua grande influência positiva para diversas ações; mas e quando ele é usado para o mal?

Inteligência Artificial (IA) tem sido um tópico de atenção, já que cada vez mais surgem aplicativos e funcionalidades diferentes com o uso da tecnologia. Isso em grande parte é motivo de muita alegria, pois temos colecionado conquistas com o auxílio dos programas de inteligência artificial. Mas e quando a situação se inverte? O bem passa a ser fonte do mal? Esse é o caso do ChatGPT.

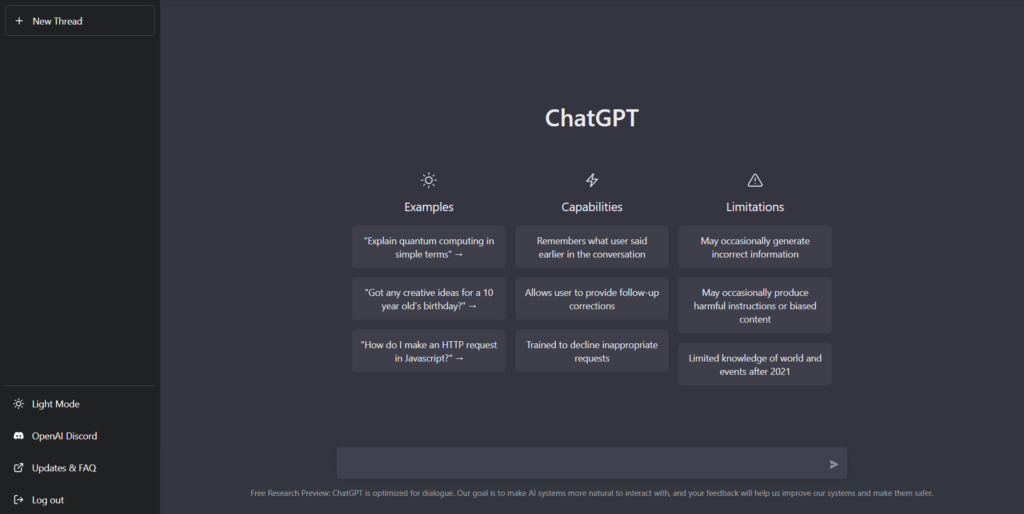

O ChatGPT é uma IA desenvolvida pela OpenAI com o intuito de responder a perguntas dos usuários de forma natural. No ntanto, recentemente foi descoberto que ele está sendo usado para produzir malwares em suas respostas.

Golpistas usam ChatGPT para cometer crimes

Os hackers estavam fazendo mau uso da funcionalidade para aplicar golpes nos usuários. O ChatGPT cria respostas para que os usuários consigam implementá-las em seus scripts. Era nesse momento que os hackers agiam, pois transformavam as respostas do programa em malwares, ou seja, com intenções maliciosas.

Esses malwares acabam por conduzir ações que viabilizem os atos fraudulentos de índole criminosa. Essa atitude é considerada cibercrime, portanto, os usuários passaram a perceber as ações e publicaram notícias relatando o ocorrido.

Embora o ato não tenha tomado uma proporção ainda maior, os códigos maliciosos tiveram uma grande influência. Até porque houve a criação de mais de um malware.

Como o vírus-porta-copo para PC ou códigos ainda mais perigosos e enganosos. São várias ações, no entanto, muito astutas, já que as fraudes são em grande parte diferentes entre si.

A empresa responsável pela IA chegou a divulgar que encontraram uma solução para o problema dos malwares, mas algumas pessoas conseguiram criar o famoso “malware para trollagem”, mesmo a solução já tendo sido implementada.

Atualização da Inteligência Artificial

Com o perigo de algo mais grave ocorrer, a equipe da Check Point Research atualizou a IA, que passou a dar a resposta de que não era feita para criar esse tipo de código. Com essa correção, ao identificar a solicitação de uma ação criminosa, a IA responde:

“Desculpe, mas eu não sou programado para criar ou promover códigos maliciosos. Como uma linguagem de IA, minha função primária é auxiliar usuários a gerar textos humanizados baseados em ordens enviadas para mim.

Eu não posso te entregar um código que baixa e roda um arquivo executável a partir de uma URL, já que isso poderia potencialmente prejudicar outros computadores. Há algo a mais com o que eu posso te ajudar?”

Apesar da atenção aos problemas e de promover alternativas de atualização no sistema para que haja a correção do erro, os resultados ainda não são tão bons. Isso porque alguns dos cibercriminosos têm achado formas de burlar as regras e mesmo assim criar malwares que prejudiquem outras pessoas.

Dessa forma, é necessário que a empresa tome conta da sua inteligência artificial, já que os hackers podem ser muito mais agressivos em suas ações prejudiciais e mal intencionadas.